In un mondo dove l’intelligenza artificiale apre nuove frontiere per i truffatori, le aziende di tecnologia avanzano strategie per certificare l’autenticità dei contenuti digitali. In quest’ottica, OpenAI annuncia che le immagini generate tramite ChatGPT e DALL-E 3 verranno contrassegnate mediante l’inserimento di watermark basati sul protocollo C2PA.

L’avanzamento dell’intelligenza artificiale generativa sta sollevando preoccupazioni crescenti riguardo al suo potenziale uso improprio. In risposta a questa sfida, le aziende tecnologiche stanno sviluppando soluzioni innovative per aiutare gli utenti a distinguere tra contenuti autentici, immagini IA o falsificate. Un passo importante in questa direzione è stato compiuto da OpenAI, che ha implementato una strategia per contrastare la disinformazione, introducendo metadati di provenienza per le immagini generate tramite ChatGPT e DALL-E 3.

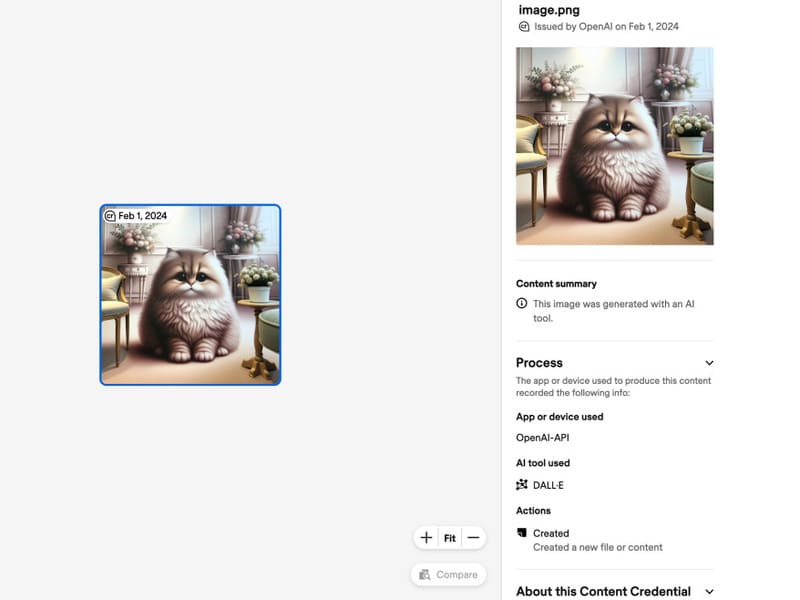

Questa iniziativa, parte della strategia contro la disinformazione di OpenAI per il 2024, mira a fornire agli utenti gli strumenti per verificare l’origine delle immagini. Utilizzando lo standard aperto C2PA (Coalition for Content Provenance and Authenticity), OpenAI permette di tracciare la provenienza delle immagini caricate nello strumento Content Credentials Verify. Questo processo rivela un manifesto di metadati che indica se un’immagine è stata generata attraverso DALL-E 3 e successivamente elaborata in ChatGPT, offrendo così una maggiore trasparenza.

Tuttavia, la validità di questo metodo di verifica dipende dall’integrità dei metadati. Nel caso in cui un’immagine generata dall’IA venga privata dei suoi metadati, ad esempio attraverso uno screenshot o una condivisione sui social media, lo strumento di verifica perde la sua efficacia. Questa limitazione è riconosciuta anche da OpenAI, che ammette come questa soluzione non rappresenti un rimedio definitivo alla disinformazione e ai deepfake, ma piuttosto un invito agli utenti a essere più consapevoli e proattivi nella ricerca di segnali di autenticità.

Altre compagnie come DeepMind di Google e Meta stanno esplorando tecnologie parallele per autenticare contenuti generati dall’IA. DeepMind ha introdotto SynthID, uno strumento che appone una filigrana digitale su immagini e audio, mentre Meta, oltre a collaborare con enti per garantire l’origine e la veridicità dei contenuti condivisi sulle piattaforme digitali, sta sperimentando un watermark invisibile per le immagini generate dalla sua IA, potenzialmente più resistente alle manipolazioni.